Découvrez les différentes fonctionnalités de Dataiku, pour saisir tout le potentiel du Data Science Studio. À travers ce dossier, vous comprendrez pourquoi cette plateforme est devenue incontournable pour les Data Scientists !

Au cours d’une journée de travail, les Data Scientists doivent effectuer de nombreuses tâches différentes : préparation des données, DataViz, analyse, création de modèles de Machine Learning…

Lorsqu’ils sont effectués manuellement, ces travaux peuvent rapidement devenir chronophages et répétitifs. Heureusement, il existe des outils et des logiciels permettant d’automatiser ou de simplifier les processus. L’une de ces plateformes est le Data Science Studio de Dataiku.

Qu'est-ce que Dataiku ?

La startup Dataiku fut initialement fondée à Paris par Florian Douetteau, Clément Stenac, Thomas Cabrol et Marc Batty. Rapidement, elle a rencontré le succès et s’est installée à New York en 2015.

En cause ? Sa plateforme IA Dataiku DSS (Data Science Studio) permettant aux professionnels des données de collaborer. Au sein de cet environnement centralisé, les Data Scientists, Data Engineers, Data Analysts, Data Architects peuvent travailler avec les équipes CRM et marketing.

Ce logiciel simplifie la manipulation des données, l’analyse, le partage, les prédictions et la création de modèles d’intelligence artificielle. Quelques clics suffisent pour effectuer ces tâches essentielles de la Data Science.

En outre, DSS simplifie l’automatisation et l’industrialisation de la collecte et la préparation de données, et de l’entraînement, du testing et du monitoring des modèles IA et de la phase de déploiement en production.

Cette plateforme est utilisée pour une large variété d’applications comme la segmentation et le scoring de clients, la détection de fraude, le Deep Learning ou le traitement naturel de langage (NLP).

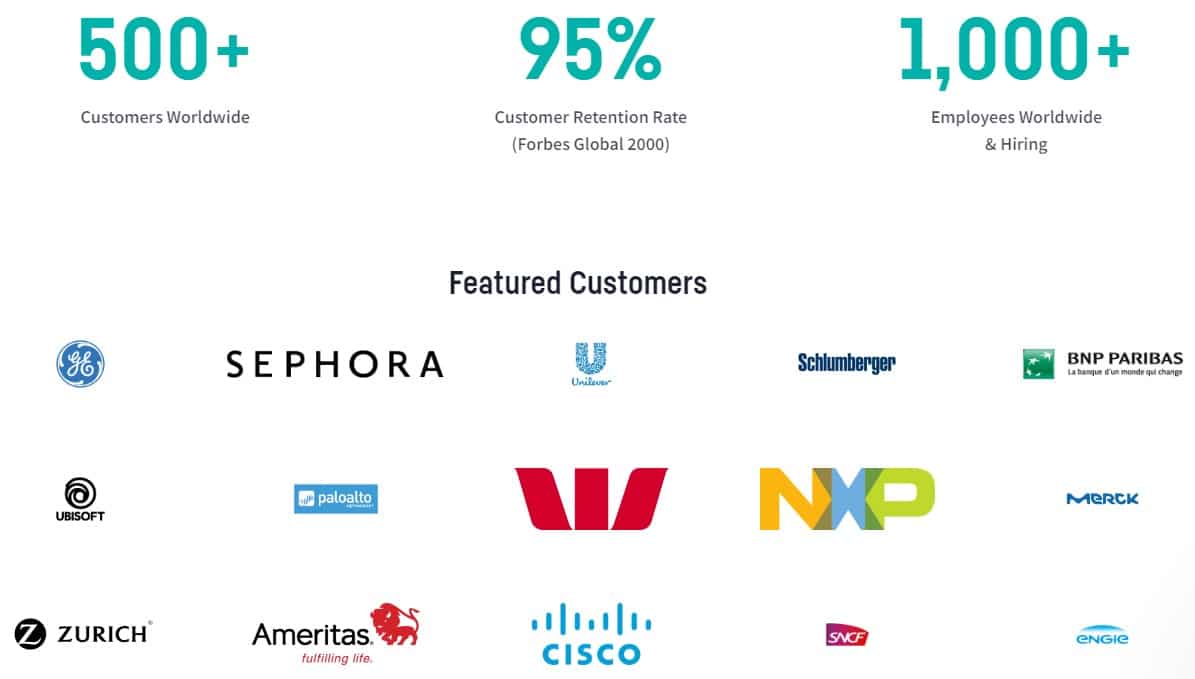

Grâce au succès du Data Science Studio, Dataiku a levé 101 millions de dollars en 2018 puis 400 millions de dollars en 2021. Parmi les investisseurs, on retrouve CapitalG (Google), Snowflake Ventures ou encore Battery Ventures.

Avec une capitalisation totale dépassant les 4 milliards de dollars, la petite startup française est devenue une licorne et compte plus de 1000 employés.

Parmi plus de 450 clients, on compte les plus grands groupes mondiaux, dont les entreprises françaises Accor, BNP Paribas, Engie, LVMH, Morgan Stanley, UBS ou Walmart. Au total, la plateforme fédère 45 000 utilisateurs actifs.

Extrêmement complète et polyvalente, la plateforme Data Science Studio de Dataiku propose plus de 90 fonctionnalités. Toutefois, ces nombreuses capacités sont réparties entre plusieurs catégories principales à découvrir dans la suite de ce dossier.

Comment Dataiku prépare les données ?

Dataiku permet à la fois aux codeurs et aux non-codeurs d’accéder, explorer et préparer les données d’un projet au sein d’un espace partagé. Il est possible d’utiliser le code ou une interface visuelle pour nettoyer, combiner, transformer ou enrichir tous types de jeux de données. Les données peuvent être préparées pour les projets d’analyse ou de Machine Learning.

Le « Visual Flow » offre une représentation visuelle des étapes du pipeline de données d’un projet. Il s’agit de l’espace central permettant aux codeurs et non-codeurs de voir et d’analyser les données, de combiner et transformer les datasets ou construire des modèles prédictifs. Ce flux visuel contient aussi des éléments de plugin et de code pour la customisation et l’extension.

Les interfaces visuelles intuitives permettent la fusion de jeux de données, mais aussi l’agrégation, la transformation, le nettoyage et l’enrichissement des données en quelques clics. Les codeurs peuvent aussi utiliser les principaux langages comme Python, R et SQL au sein de n’importe quel IDE.

Des dizaines de connecteurs sont disponibles pour de nombreuses sources de données sur site et sur le cloud. En guise d’exemples, on peut citer Amazon S3, Azure Blob Storage, Google Cloud Storage, Snowflake, HDFS, ou encore les bases de données SQL et NoSQL.

Plus d’une centaine de transformateurs de données sont également inclus, pour les manipulations de données les plus communes comme le binning ou la conversion de date et de devise. Mieux encore : Dataiku suggère des fonctions pertinentes en se basant sur le type et les valeurs des données.

Pour la préparation de données spécialisée, Dataiku offre une large variété d’outils et de fonctions permettant l’analyse ou l’enrichissement de types de données spécifiques comme les données géospatiales, les séries temporelles, les images ou les textes.

Visualisation de données

Les nombreuses fonctionnalités DataViz de Dataiku permettent d’accélérer l’analyse exploratoire et le reporting. On retrouve notamment des capacités de profilage de données, d’analyse statistique et de charting.

Une large variété de graphiques et diagrammes sont disponibles pour visualiser les données, tels que des diagrammes en barre, en ligne, des cartes de chaleur, des distributions 2D ou des nuages de points.

Par la suite, les tableaux de bord interactifs simplifient le partage de données et d’informations avec les différentes parties prenantes. Ces dashboards sont mis à jour automatiquement.

Pour l’analyse exploratoire, Dataiku fournit des fonctionnalités de profilage automatique des colonnes. Ceci inclut le compte et la distribution des valeurs, des colonnes invalides ou erronées et des statistiques de synthèse. Les indicateurs de qualité des données pour chaque colonne permettent de visualiser immédiatement les valeurs manquantes ou invalides.

En outre, Dataiku inclut une large gamme de tests et d’analyses statistiques. On peut mentionner les analyses univariées et multivariées, les courbes d’ajustement, les tests de distribution ou les analyses de séries temporelles.

Grâce à l’assistant intelligent, les patterns pertinentes peuvent être découvertes par l’exploration automatique des données. Le but est d’identifier les relations intéressantes entre les données, représentées de façon visuelle.

Dans certaines situations, l’usage d’outils de Business Intelligence tiers est requis pour communiquer avec les parties prenantes ou les utilisateurs métiers. C’est pourquoi Dataiku s’intègre avec les plateformes populaires telles que Power BI, Tableau et Qlik.

Quelle fonctionnalité peut-être utilisée en Machine Learning ?

Avec Dataiku AutoML, le processus de développement de modèle de Machine Learning est fortement accéléré grâce à une interface visuelle guidée. Une explicabilité en boîte blanche permet aux Data Scientists et aux analystes de construire et de comparer de multiples modèles prêts pour la production.

La plateforme regroupe les meilleurs algorithmes pour de nombreuses tâches de Machine Learning comme la prédiction, le clustering, la prévision de séries temporelles ou la Vision par Ordinateur.

Afin de simplifier le processus d’ingénierie de caractéristiques, les Data Scientists peuvent consulter les jeux de caractéristiques de référence au sein du catalogue Dataiku et les importer dans leurs projets.

De plus, AutoML permet la génération automatique de caractéristiques, et offre des techniques de réduction. Les stratégies de prises en charge peuvent être appliquées pour la sélection de caractéristiques, les valeurs manquantes, l’encodage de variables ou le rescaling basé sur le type de données.

Afin d’étendre les possibilités offertes par l’interface de Machine Learning visuelle, les Data Scientists les plus avancés peuvent ajouter des algorithmes Python customisés. Ils peuvent également développer leurs propres modèles en utilisant Python, R, Scala, Julia, Pyspark ou d’autres langages.

Tous les détails de ces expériences sont enregistrés par Dataiku, et des comparaisons de modèles et rapports d’explicabilité sont automatiquement fournis pour permettre l’interprétation par le reste de l’équipe. Ainsi, DSS fait office de plateforme centrale pour le déploiement, le monitoring et la gouvernance de modèles ML.

On retrouve aussi de nombreuses fonctionnalités pour la validation et l’évaluation de modèles, de la conception au déploiement. Les Data Scientists peuvent profiter de tests de validation croisée k-fold et de diagnostics automatiques pour vérifier la santé des modèles pendant la phase d’expérimentation.

Parmi les rapports d’interprétation et performances interactifs, on retrouve l’analyse what-if, l’analyse d’équité ou encore les stress tests. Ceci permet aux équipes d’expliquer leurs résultats et de délivrer des modèles fiables et précis.

Grâce à son UX simple et intuitive de construction de modèles, Dataiku simplifie l’inclusion du Deep Learning aux projets data et aux applications métier. Les utilisateurs peuvent définir des architectures custom avec Keras et Tensorflow, ou exploiter les modèles pré-entraînés, l’apprentissage par transfert et les interfaces no-code pour les tâches de vision par ordinateur comme la détection d’objets ou la classification d’images.

Enfin, pour les tâches d’entraînement de modèle les plus ambitieuses, Dataiku permet le scaling automatique des workloads grâce à des ressources élastiques à la demande basées sur Spark et Kubernetes sur n’importe quel cloud. Les clusters gérés et pré-configurés éliminent la complexité des infrastructures conteneurisées, laissant les Data Scientists se concentrer sur des tâches plus importantes.

Qu'en est-il des fonctionnalités DataOps ?

Les fonctionnalités DataOps de Dataiku permettent d’automatiser les pipelines de données, et de configurer un système d’alerte pour que toutes les équipes de l’entreprise puissent accéder à des données propres et fiables.

Chaque projet Dataiku est doté d’un flux visuel représentant le pipeline de transformations et de mouvement des données du début à la fin. Une chronologie retraçant l’activité récente et une documentation automatique du flux simplifient le suivi des changements et la gestion de version en production.

Par ailleurs, Dataiku permet le déploiement en batch ou en temps réel. Le déployeur central de Dataiku permet de superviser les deux types de déploiements, tandis que des tableaux de bord et des logs d’événements aident les opérateurs de données à surveiller continuellement les systèmes pour détecter les problèmes éventuels.

Les bundles de projet offrent un snapshot des données, de la logique et des dépendances requises pour recréer et exécuter les pipelines au sein d’un environnement en production. Des tâches planifiées peuvent être exécutées, et les éléments peuvent être exposés en tant qu’API REST pour soutenir les applications en temps réel.

Différentes métriques évaluent automatiquement les données ou les éléments de modèles pour identifier les changements de qualité ou de validité. De même, des vérifications assurent que les flux planifiés s’exécutent en temps voulu et que les métriques délivrent les résultats escomptés.

Les équipes peuvent aussi configurer des alertes et des notifications, afin de garder le contrôle requis pour gérer les pipelines de production de façon sûre sans avoir besoin d’un monitoring manuel constant.

La fonctionnalité de scénarios est également très utile pour automatiser les tâches séquentielles répétitives. Ceci inclut le chargement et le traitement de données, l’exécution de tâches de scoring en batch, le ré-entraînement des modèles ou encore la mise à jour de la documentation.

Ces scénarios peuvent être exécutés à l’aide de l’interface visuelle ou programmatiquement à l’aide d’APIs. Les opérateurs peuvent donc configurer l’exécution du pipeline, à l’aide de déclencheurs basés sur le temps ou sur des conditions.

Autre avantage des fonctionnalités DataOps : éviter les interruptions de connexions, les dépendances brisées ou la perte de synchronisation des schémas. Divers outils aident les opérateurs à gérer les dépendances de pipeline, vérifier la cohérence des schémas et reconstruire intelligemment les datasets pour refléter les mises à jour récentes.

Enfin, l’intégration Git offre des capacités de gestion de version et de traçabilité pour les projets de données. Les équipes peuvent aisément incorporer des bibliothèques, notebooks et dépôts externes pour le développement de code ou le CI/CD.

Une fonctionnalité dédiée au MLOps

Dataiku s’illustre comme une plateforme complète pour le développement, le déploiement, la surveillance et la maintenance des modèles de Machine Learning.

Le déployeur fait office d’emplacement central pour le scoring par batch ou en temps réel, permettant aux opérateurs de gérer les versions des projets Dataiku et le déploiement d’API dans les environnements de développement, test et production.

Pour les opérations batch, les nœuds d’automatisation Dataiku sont des serveurs de production dédiés exécutant des scénarios pour les tâches de production du quotidien comme la mise à jour des données, le rafraîchissement de pipelines, le monitoring ou le ré-entraînement de modèles basé sur une planification ou des déclencheurs.

Ces serveurs d’exécution dédiés permettent à de multiples projets IA de tourner de façon fluide, au sein d’un environnement de production fiable et isolé.

En outre, les nœuds API de Dataiku forment une infrastructure élastique et hautement disponible ajustant dynamiquement les ressources cloud pour répondre aux changements de besoins. Quelques clics suffisent pour générer des endpoints REST API pour l’inférence de modèle en temps réel, les fonctions de code ou les requêtes SQL. Ceci permet de laisser l’IA propulser davantage d’applications et de processus.

Plusieurs fonctionnalités aident les équipes à prendre des décisions judicieuses quant aux choix des modèles à déployer en production. On peut citer la détection automatique de dérive et le ré-entraînement, le suivi d’expérience, ou encore l’évaluation et la comparaison de modèles.

Une fois les projets IA en production, Dataiku surveille le pipeline pour s’assurer que tous les processus s’exécutent comme prévu et alerte les opérateurs en cas de problèmes. Grâce aux métriques de performances, les modèles live continuent à délivrer des résultats de haute qualité au fil du temps. En cas de dégradation, l’analyse de dérive aide les opérateurs à détecter et enquêter pour prendre les mesures adéquates.

Si une mise à jour est requise pour un modèle en production, les équipes peuvent effectuer un refactoring manuel ou configurer un ré-entraînement automatique basé sur une planification ou des déclencheurs.

Grâce aux APIs, les opérateurs ML et IT peuvent effectuer les opérations Dataiku depuis des systèmes d’orchestration externes et incorporer les tâches MLOps aux workflows de données existants. La plateforme s’intègre avec les principaux outils DevOps comme Jenkins, GitLabCI, Travis CI et Azure Pipelines.

Enfin, les MLOps peuvent effectuer des stress tests pour simuler les problèmes de qualité de données du monde réel. Ceci permet de réduire les risques en évaluant la solidité d’un modèle et son comportement sous conditions hostiles avant le déploiement.

La documentation générée automatiquement pour les modèles et les pipelines permet aussi aux équipes de sauvegarder le contexte des projets essentiels, à des fins de reproductibilité et de conformité.

Est il possible de Applications analytiques

Dataiku permet de créer très facilement des applications et des tableaux de bord analytiques. Par la suite, il est possible de partager avec les utilisateurs métier pour soutenir la prise de décision.

Les tableaux de bord interactifs incluent divers éléments tels que des jeux de données et des diagrammes filtrables, des insights de modèle de Machine Learning, des métriques de santé de projet, des applications web intégrées et bien plus encore. Les mises à jour de données peuvent être planifiées ou activées par des déclencheurs en toute simplicité pour que les utilisateurs métier aient accès aux derniers indicateurs clés de performances.

Cette plateforme permet aussi d’effectuer des analyses d’hypothèses « what if », pour tester interactivement différentes combinaisons de valeurs entrantes et examiner l’impact sur les résultats prédits. De puissantes fonctionnalités de simulation aident également à découvrir quels changements spécifiques de caractéristiques permettent d’atteindre le résultat désiré. Les utilisateurs techniques et métiers peuvent ainsi se fier à cet outil d’aide à la décision.

Il n’est pas nécessaire de coder pour créer des Applications Dataiku. Les Data Scientists et les analystes métier peuvent créer et délivrer des applications customisées pour tous les consommateurs de données à l’aide d’une interface visuelle intuitive. Toute l’organisation peut ensuite interagir avec des analyses pré-construites en self-service avec leurs propres données.

En outre, Dataiku prend en charge le développement d’applications web interactives de la conception à la livraison. Les utilisateurs métiers peuvent donc utiliser les données et insights prédictives interactivement pour offrir une meilleure expérience client et des résultats améliorés. Les templates visuels pré-construits peuvent être configurés, mais il est aussi possible de coder une application web entièrement customisée à l’aide de frameworks comme Dash, Bokeh, R SHiny, JavaScript et Streamlit.

Enfin, les assets de données et les résultats peuvent être compilés et partagés par le biais d’espaces de travail. Ces points d’accès permettent aux utilisateurs techniques ou non techniques d’accéder très facilement à une variété d’objets sourcés depuis de multiples projets : applications, tableaux de bord, jeux de données…

Comment suivre une formation Dataiku ?

Vous l’aurez compris : Dataiku rassemble une multitude de fonctionnalités permettant de mener à bien toutes les tâches de Data Science et Machine Learning.

Toutefois, pour exploiter pleinement le potentiel de cet outil, il est nécessaire de maîtriser toutes ses facettes et subtilités. Afin d’acquérir cette expertise, vous pouvez choisir DataScientest.

Nous proposons des formations aux différents métiers de la Data Science : Data Scientist, Data Analyst, Data Engineer, ou encore Data Product Manager. Par ailleurs, nos cursus spécialisés permettent de maîtriser des outils spécifiques tels que Dataiku, Power BI ou Excel.

Toutes nos formations s’effectuent entièrement à distance via le web, en mode BootCamp intensif ou Formation Continue. Pour le financement, notre organisme reconnu par l’Etat est éligible au Compte Personnel de Formation. Découvrez DataScientest pour apprendre à maîtriser Dataiku !

Vous savez tout sur les fonctionnalités Dataiku. Pour plus d’informations sur le même sujet, découvrez notre dossier complet sur la Data Science et notre dossier sur le Machine Learning.